Mit langsamen, gleichmäßigen Bewegungen schreibt der Roboterarm auf einem weißen Blatt Papier, das vor ihm auf dem Tisch klebt. Er arbeitet sich Buchstabe für Buchstabe voran – doch plötzlich geschieht etwas Unerwartetes: Der Arm mit dem anmontierten Stift unterbricht das Schreiben, streckt sich rasch weit über das Papier hinaus nach hinten und holt sich einen anderen Stift. Danach setzt er seine ruhige Arbeit fort, als wäre nichts Außergewöhnliches geschehen.

Diese Szene ist Teil eines Experiments, das Prof. Dr. Myra Spiliopoulou, Professorin für Wirtschaftsinformatik, und Prof. Dr. Frank Ortmeier, Professor für Software Engineering, im Roboterlabor der Fakultät für Informatik an der Otto-von-Guericke-Universität Magdeburg, gerade durchführen. Ihr Ziel: Sie möchten herausfinden, wie Menschen auf diese Situation reagieren. Fühlen sie sich überrascht, abgelenkt oder unsicher? In den künftigen Experimenten sollen Videokameras die Gestik und Mimik der Probandinnen und Probanden aufzeichnen. Zusätzlich messen Sensoren ihren Herzschlag und die elektrodermale Aktivität auf der Haut. Die Sensorik generiert hochdimensionale Datenströme, deren Muster Myra Spiliopoulou und ihr Team mithilfe von Künstlicher Intelligenz (KI) analysieren, um in ihnen Stress und Anspannung zu erkennen. So wollen sie besser verstehen, wie Mensch und Roboter aufeinander wirken und wie die menschlichen Reaktionen auch ohne aufwendige Sensorik am Körper, etwa durch Bild und Ton, erfasst werden können.

Intuitiv und flexibel wie der Mensch

Die Versuche sind erste Schritte eines großen Vorhabens, an dem auch andere Arbeitsgruppen aus der Universität Magdeburg, der Technischen Universität Chemnitz und der Technischen Universität Ilmenau beteiligt sind. Die drei Universitäten arbeiten bereits seit 2008 im Forschungs- und Innovationsnetzwerk Chemnitz-Ilmenau-Magdeburg (CHIM) eng zusammen. Mit „Productive Teaming“ wollen sie nun in den Exzellenzwettbewerb gehen und gemeinsam einen grundlegende Paradigmenwechsel in der industriellen Produktion anstoßen. Denn die sei nicht mehr zeitgemäß, erklärt Prof. Dr. Frank Ortmeier, Professor für Software Engineering an der Universität Magdeburg.

Prof. Ortmeier (Foto: Jana Dünnhaupt / Uni Magdeburg)

Prof. Ortmeier (Foto: Jana Dünnhaupt / Uni Magdeburg)

„Produktionsstrecken, wie wir sie heute etwa in der Autoindustrie kennen, sind hoch effizient“, betont er. Doch die Nachteile, die mit dieser Form der Automatisierung verbunden sind, wiegen schwer. „Dass wir eine Wegwerfgesellschaft sind und keine Kreislaufwirtschaft haben, liegt auch an unseren Produktionsprozessen“, sagt Frank Ortmeier. „Geräte neu zu produzieren ist häufig viel preiswerter, als sie zu reparieren.“ Das verbraucht unnötig viele Ressourcen und Energie. Außerdem sei der Mensch an den hochautomatisierten, statischen Produktionsstrecken – überspitzt formuliert – zum Sklaven der Maschinen geworden.

„Warum können wir Maschinen nicht so gestalten, dass sie wie Menschen mit uns zusammenarbeiten, intuitiv und flexibel?“, fragt Frank Ortmeier und arbeitet an genau dieser Vision eines „Productive Teaming“. Bisher können Roboter z.B. nicht verstehen, ob jemand unsicher oder müde ist, Rückenschmerzen hat oder auf eine Veränderung in der Umgebung reagieren muss. Diese Fähigkeiten wollen die Forschenden den Maschinen beibringen.

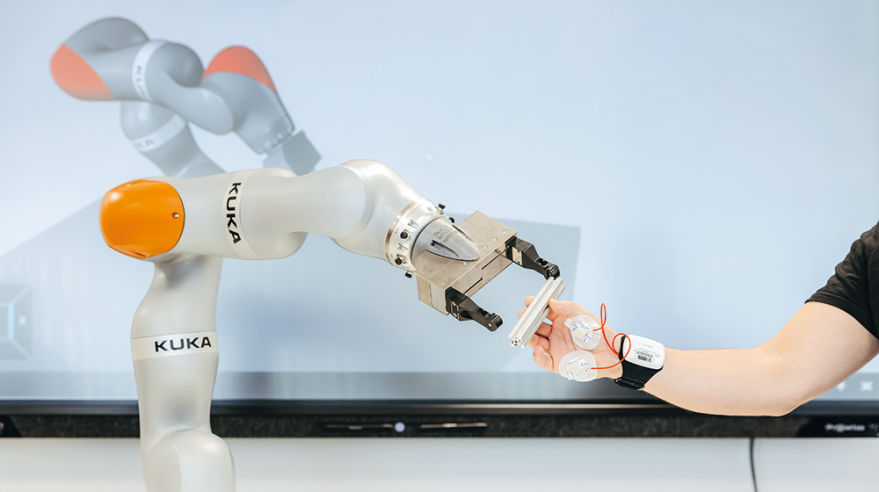

Einige der dafür notwendigen Grundlagen legen die Forschenden in Experimenten mit dem schreibenden Roboter, einem sogenannten Cobot, der mit zahlreichen Sensoren in seinen Gelenken ausgerüstet ist. Mit ihnen kann er auf Berührungen reagieren und schnell anhalten, um etwa Kollisionen zu vermeiden. Nadia Schillreff arbeitet als Doktorandin im Roboterlabor und erklärt, was einen solchen kollaborativen Roboter außerdem von anderen unterscheidet: „Er verhält sich ähnlich wie ein menschlicher Arm, hat die gleiche Flexibilität, mit einem Schulter-, Ellenbogen- und Handgelenk.“ Normalerweise arbeitet ein solcher Cobot, der auch Dinge greifen, heben und bewegen kann, sehr ruhig und gemächlich – außer, jemand programmiert ihm, wie für das oben genannte Experiment, unerwartete Bewegungen ein.

Ein ‚kognitiv augmentierter’ Roboter bearbeitet flexibel und adaptiv mit einem Menschen gemeinsam eine Montageaufgabe. (Foto: Jana Dünnhaupt / Uni Magdeburg)

Ein ‚kognitiv augmentierter’ Roboter bearbeitet flexibel und adaptiv mit einem Menschen gemeinsam eine Montageaufgabe. (Foto: Jana Dünnhaupt / Uni Magdeburg)

„Wenn Mensch und Maschine kooperieren sollen, dann muss die Maschine etwas von dem beabsichtigten Ziel wissen, das Handeln des Menschen verstehen und sich sogar daran beteiligen“, beschreibt Myra Spiliopoulou eine der großen Herausforderungen für ein funktionierendes „Productive Teaming“. Wenn der Stift kaputt geht oder etwas herunterfällt, sollten Roboter erkennen, was passiert ist und darauf reagieren und sich anpassen. Ist der Mensch überrascht, etwa weil sich die Maschine plötzlich anders bewegt, sollte sie das ebenfalls erkennen und signalisieren, dass alles in Ordnung sei. Um das zu lernen, sind neue Experimente, Messverfahren, KI-Methoden und experimentelle Daten notwendig, die in Magdeburg, Chemnitz und Ilmenau entwickelt und erhoben werden.

Augen und Ohren des Roboters

Bei Prof. Dr. Gunther Notni von der Technischen Universität Ilmenau steht die dafür notwendige Sensorik und Bildverarbeitung im Mittelpunkt. Mit seinem und weiteren Teams der TU Ilmenau untersucht der Physiker und Messtechniker in seinem Labor – einer virtuell nachgestellten Produktionsumgebung –, wie Roboter mithilfe von Sensordaten lernen können, Menschen besser zu verstehen, damit beide „wie ein echtes Team“ zusammenarbeiten können. „Dafür muss der Roboter die Situation sehen, richtig einschätzen, schnell reagieren und auch wissen, was als nächstes geschieht oder gebraucht wird“, erklärt Gunther Notni. Sensoren sind dabei die Augen und Ohren des Roboters.

Zum Repertoire des Ilmenauer Forschungsteams gehören Echtzeit-3D-Sensoren, Wärmebildkameras, Geräte zur Messung von Gehirnströmen, Sensoren für akustische Signale und sogar Fasersensoren, die in die Kleidung eingewoben werden und Bewegungsabläufe und -muster bis ins kleinste Detail erfassen. All diese Daten sollen mithilfe von KI ausgewertet werden und ein umfassendes Bild darüber liefern, wie die Arbeitsabläufe aussehen, in welcher Verfassung der Mensch ist und wie sich der Roboter darauf einstellen kann. Die mit vielen experimentellen Daten gut trainierten KI-Modelle werden am Ende dazu in der Lage sein, all diese Informationen lediglich aus den Sensordaten zu erkennen, die in der industriellen Produktionsstrecke der Zukunft von den Sensoren geliefert werden.

Tragbare Sensor zur Überwachung der Vitalwerte können mithilfe von KI verwendet werden, um Emotionen zu erkennen. (Foto: Jana Dünnhaupt / Uni Magdeburg)

Tragbare Sensor zur Überwachung der Vitalwerte können mithilfe von KI verwendet werden, um Emotionen zu erkennen. (Foto: Jana Dünnhaupt / Uni Magdeburg)

Gunther Notni sieht die Zukunft von „Productive Teaming“ weniger an hochautomatisierten, standardisierten Produktionsstrecken, sondern überall dort, wo individuelle Lösungen notwendig sind. Das trifft natürlich auf Montage, Demontage und Reparatur, aber auch für den Handwerksbereich und auf Baustellen zu, wo es zudem an Fachkräften fehlt. Werden Roboter in Zukunft also Zementsäcke schleppen, Möbel montieren oder Fliesen verlegen? „In diese Richtung könnte es gehen“, bestätigt der Forscher.

Optimal produzieren und Fehler vermeiden

An einem anderen konkreten Anwendungsbeispiel arbeitet derzeit einer der Forschungspartner des CHIM-Netzwerkes: das Fraunhofer-Institut für Werkzeugmaschinen und Umformtechnik (IWU) in Chemnitz. Dabei geht es um Werkzeugmaschinen, die sich während der Arbeit durch Reibung und Abwärme erhitzen. Dadurch verringert sich die Qualität der produzierten Teile. „Die Werkzeugmaschinen werden ungenau“, erklärt Institutsleiter Prof. Dr.-Ing. Steffen Ihlenfeldt. „Und diese Ungenauigkeit versucht man durch gezielte Kühlung zu reduzieren.“

Das Kühlen verbraucht allerdings Energie und verursacht Kosten. Zu welchem Zeitpunkt und an welcher Stelle gekühlt werden muss, entscheidet erfahrenes Personal, das diese Maschinen bedient. Steffen Ihlenfeldt und sein Team entwickeln mithilfe von Sensorik, dem Erfahrungswissen der Arbeitskräfte und selbstlernenden KI-Modellen interaktive Hilfestellungen, die in Echtzeit Daten auswerten und dafür sorgen, dass Erwärmung und Abkühlung optimal ineinandergreifen. „Überall dort, wo Teile aus Metall in kleinen Serien sehr genau gefertigt werden müssen – etwa in der Luftfahrt oder im Werkzeugbau – kann dieses System den Menschen an der Maschine in Zukunft unterstützen, Ausschuss vermeiden und mit minimalem Energie- und Ressourceneinsatz produzieren“, erklärt Steffen Ihlenfeldt.

„In fünf bis zehn Jahren“, schätzt Frank Ortmeier, „würde sich ‚Productive Teaming’ technisch umsetzen lassen. Aber es ist auch eine Frage des politischen Willens“, betont er. Es gehe um einen Paradigmenwechsel, der zuerst in der Gesellschaft stattfinden müsse. Einer der wichtigsten Meilensteine auf diesem Weg sei die Akzeptanz, die mit dem Forschungsvorhaben ebenfalls vorangetrieben werden müsse. In einigen Jahren, so hofft der Wissenschaftler, ist das CHIM-Netzwerk zusammen mit rund 30 weiteren Hochschulen Teil eines internationalen Zentrums für „Productive Teaming“, das gemeinsam Datensätze aufnimmt und nutzt, KI-Modelle austauscht, Anwendungsszenarien entwickelt und das Thema in die Gesellschaft trägt.